Кто-то считает их прорывом в технологиях, кто-то — угрозой для населения, а кто-то и вовсе пока не знает, как к ним относиться. Тем не менее дипфейки на слуху. Нет-нет — и появится новая новость или видео о том, как кто-то их использовал. В статье разберем, что из себя представляют дипфейки, как они влияют на разные сферы и стоит ли переживать о личной безопасности из-за их развития.

Что такое дипфейки и как они появились

Дипфейк — это технология создания фальшивых фото, видео- или аудиозаписей, которые кажутся реальными. В основе этого процесса лежит генерация нейронных сетей. В результате этого один фрагмент фото или видео накладывается на другой. Отличить такие изменения иногда практически невозможно.

Яркий пример — видео 2021 года с якобы Морганом Фрименом, где он рассказывает о «синтетической реальности», в которой вы не будете понимать, где настоящее, а где — искусственное.

Суть дипфейков — сделать так, чтобы твоя подделка не была обнаружена. И сначала технология была доступна только узкому кругу специалистов — людям, которые работают с кино или постпродакшеном.

Но в 2017 один из пользователей Reddit выгрузил порнографические материалы с лицами знаменитостей. Они были подделкой, но привлекли внимание пользователей и вызвали интерес к технологии. С того момента фальшивые материалы стали называть ником того пользователя — DeepFake.

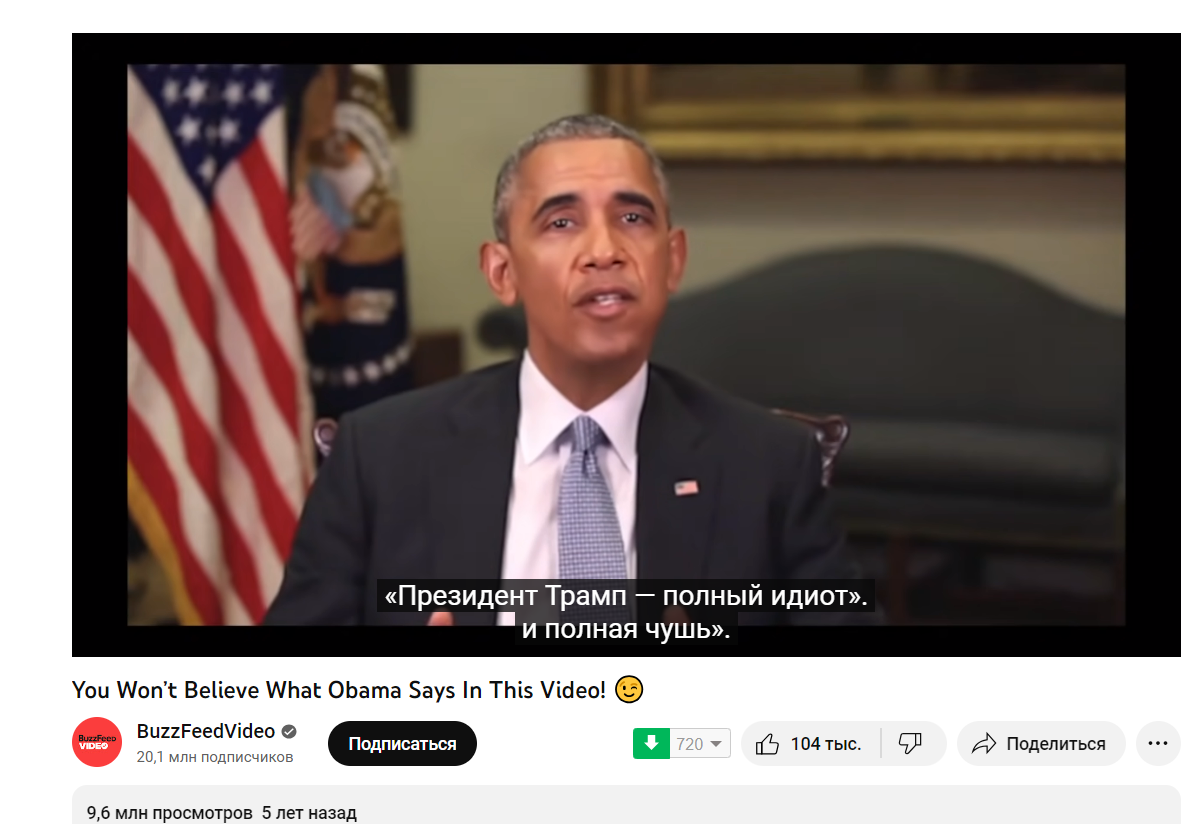

Как только технология стала доступной массовому пользователю, в сети стали появляться видеоролики со знаменитостями, политиками, актерами. Например, знаменитое видео в 2018 году, где «Барак Обама» называет Дональда Трампа «засранцем». Здесь задействовали не только видео-, но и аудиоманипуляции.

Сам видеоролик был «поучительный», как и видео с Морганом Фрименом. В нем поднимается тема веры в то, что может оказаться ненастоящим. Автор видео в описании обозначает, что это дипфейк, хотя практически во всех случаях авторы материалов стараются это скрыть.

| По данным Всемирного экономического форума, количество дипфейк-материалов увеличивается на 900% каждый год. О большей части этого обмана люди не узнают никогда — через них проходит тонна информации, на которую они даже не обращают внимания. |

По исследованиям в DeepMedia, число таких роликов к концу 2023 года достигнет минимум 500 тысяч. Число может быть больше, ведь создание фальшивых материалов становится все проще — спасибо за это продвинутым нейросетям.

Процесс состоит из нескольких шагов:

- Сбор данных: сначала нужно собрать много изображений и аудиозаписей для обучения искусственного интеллекта. Эти данные могут быть взяты из общедоступных источников, таких как социальные сети, интервью или фильмы.

- Обучение модели: с помощью машинного обучения создают модель, которая анализирует и изучает данные. Она пытается выявить паттерны в движениях губ, мимике, интонациях и речи, чтобы воссоздать их в будущем.

- Создание фейка: после обучения модель используют для создания фейковых видео или аудиозаписей, где лица, например, могут произносить фразы, которых они никогда не говорили.

- Усовершенствование: со временем модель становится точной и делает дипфейки реалистичными.

Создание фейковых роликов — сложная техническая задача. Дальше рассмотрим конкретную программу, которая помогает это реализовать.

Внутренняя «кухня»: как создают дипфейки

Технология использует два алгоритма — генератор и дискриминатор — для создания и уточнения фейкового контента. Генератор создает набор обучающих данных на основе нужного результата, создавая исходный фальшивый цифровой контент. А дискриминатор анализирует, насколько реалистичной или фальшивой стала первоначальная версия контента.

Этот процесс повторяется, позволяя генератору улучшить создание реалистичного контента, а дискриминатору стать «опытным» в обнаружении недостатков, которые генератор должен исправить.

Онлайн-генераторы могут справиться с задачей и сделать простенький ролик. Но они сделают все настолько плохо, что фейк можно увидеть без всяких проблем. Поэтому для качественного контента используют сложные программы.

Хотя сервисы генерации дипфейков сейчас стали доступны обычному пользователю, сделать свой фейковый ролик все еще сложно. На качественную работу нужно потратить время:

- Чем сложнее мимика и артикуляция человека на исходном видео, тем больше времени придется потратить на замену лица. И если люди на видео разного типажа, с абсолютно разными лицами, то задача усложняется.

- Ваш компьютер должен отвечать минимальным требованиям — процессор с поддержкой SSE-инструкций, 2 Гб ОЗУ, OpenCL-совместимая видеокарта. При этом есть риск, что в моменте железо «полетит» и один ролик на 15 секунд будет грузиться сутками.

- Взять и свести 2 видео вместе не получится. Пока нет программы, которая могла бы сделать такое. Если хочется сделать хороший ролик, придется разбираться в структуре данных и алгоритме. И неудачных вариантов сначала будет много.

Сейчас уже есть много возможностей для переноса изображения с одного видео на другое. Разберем самый распространенный из них.

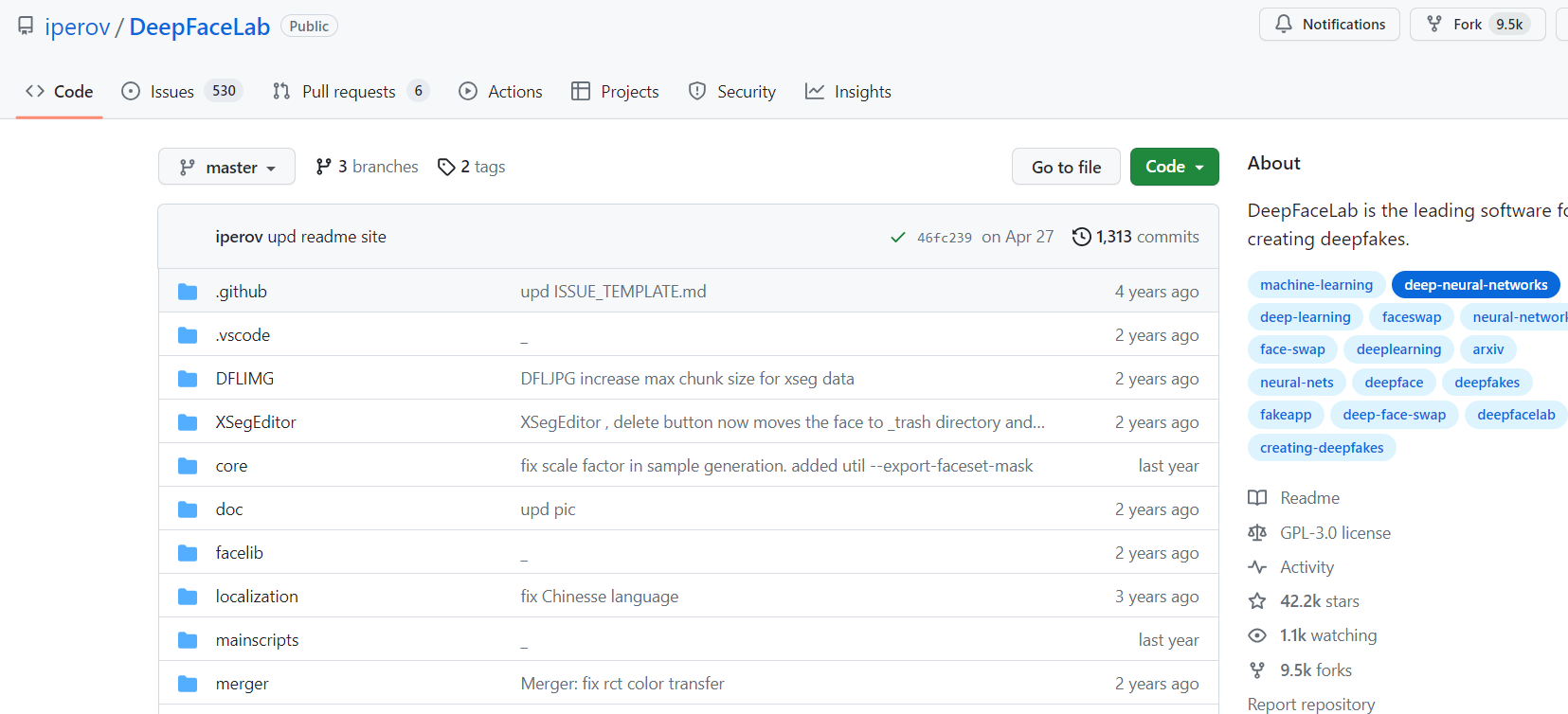

DeepFaceLab

Чтобы создать собственный ролик в программе, придется потратить время. Скачать нейросеть можно с официальной страницы на GitHub. Там же можно выбрать, будете вы скачивать ее на Windows или же на Linux.

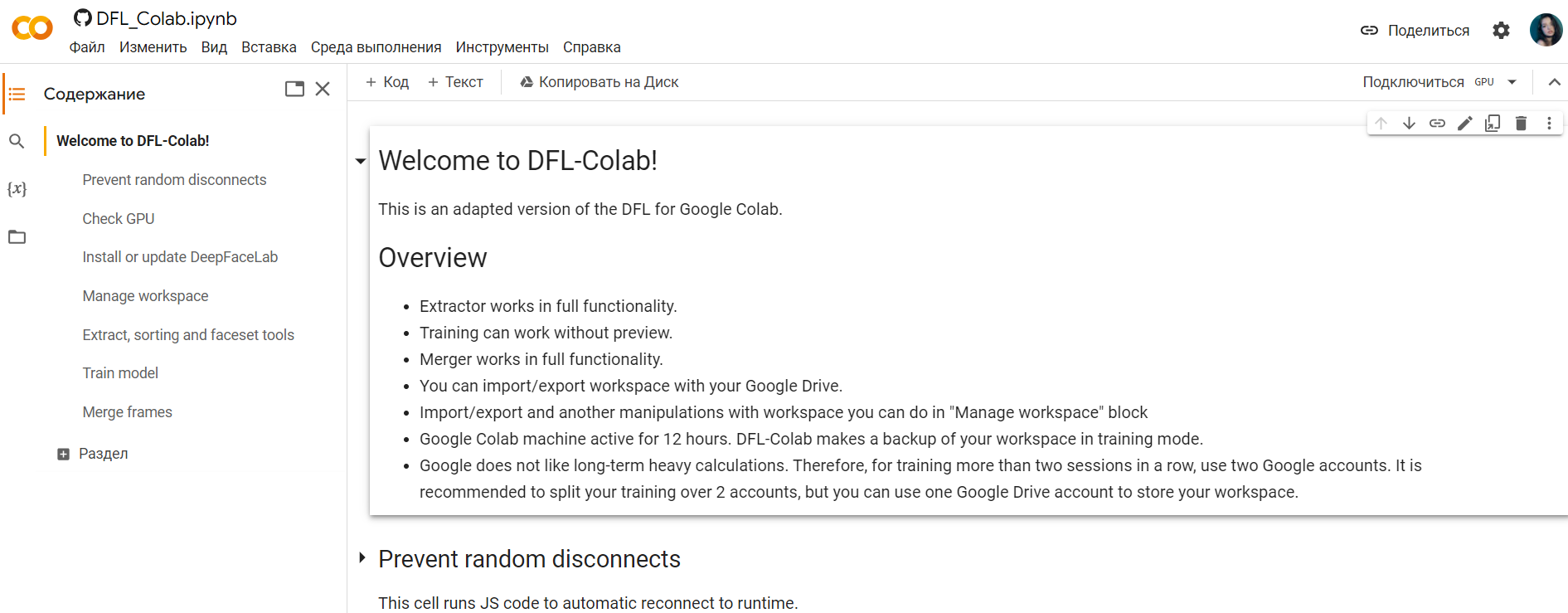

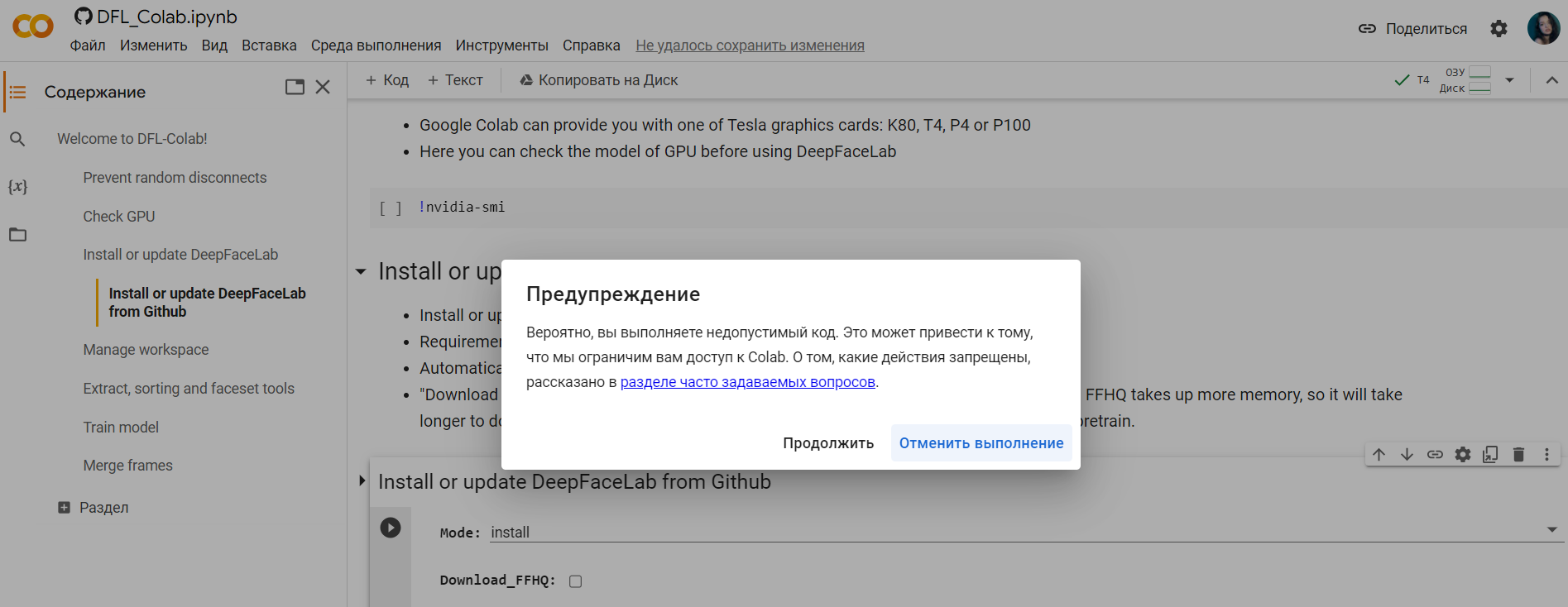

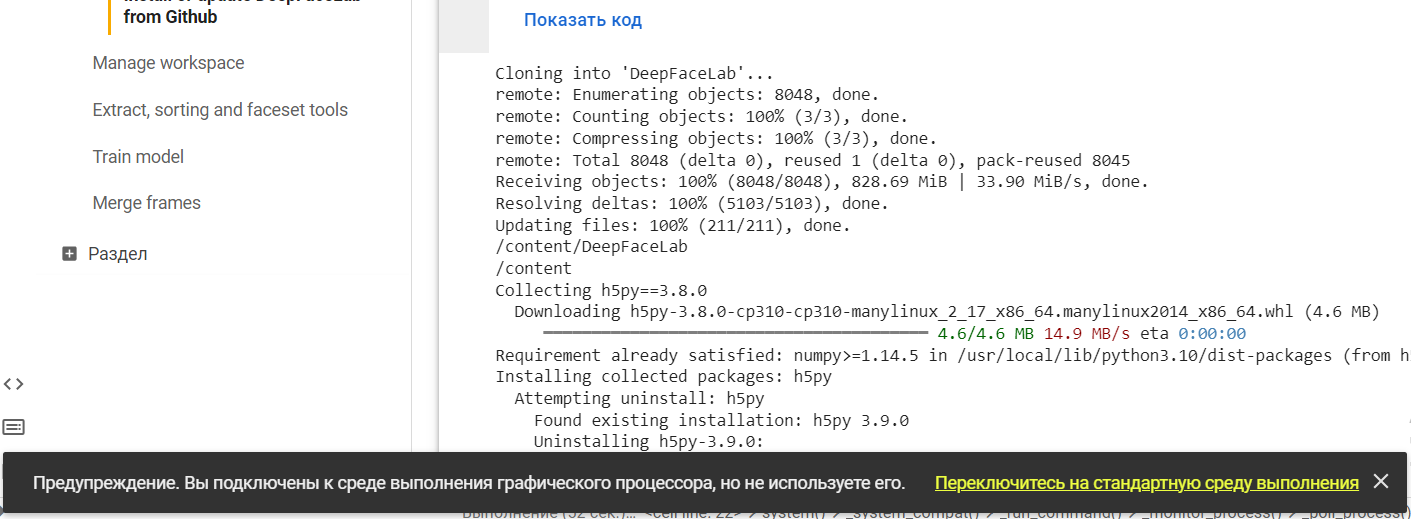

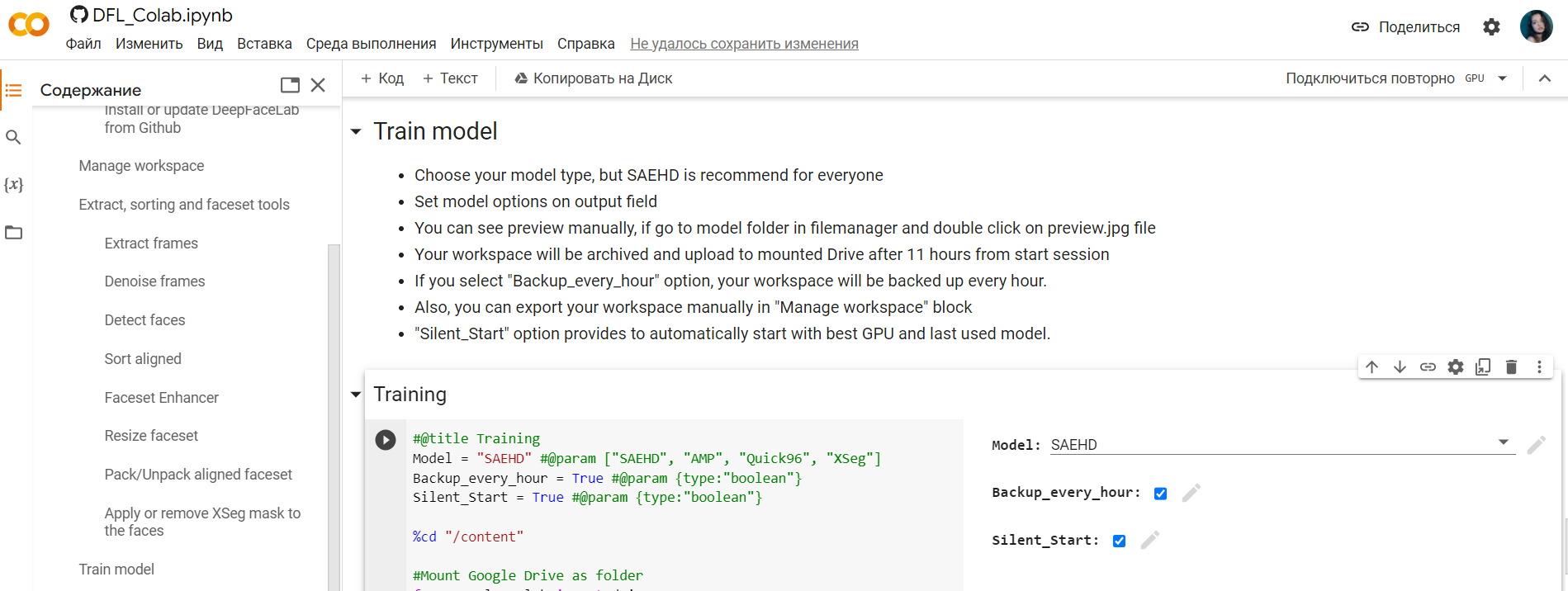

В библиотеке сейчас есть несколько релизов. Опишем создание дипфейка на базе Windows. Чтобы не загружать архив в компьютер и не мучиться с его распаковкой, можно выполнять все действия в Google Colab. Для этого зайдите в аккаунт Google под своим ником и начинайте работу в Colab.

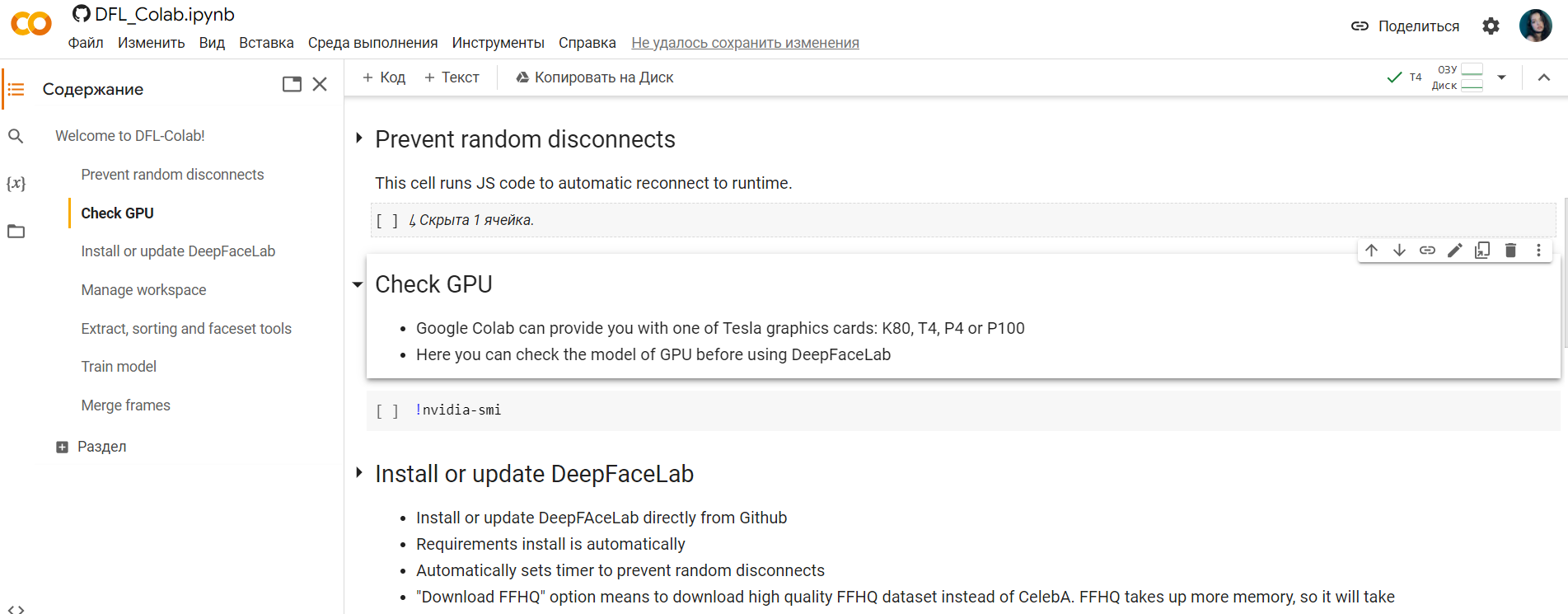

Сначала нужно запустить код «Prevent random disconnects», чтобы компьютер внезапно не перегрузился в случае неполадок с сетью. Рекомендуем проверить через «Check GPU», какую модель карты выделили для вашей сессии.

После проверки нужно загрузить рабочую среду, заархивировав каталог workspace с двумя файлами в нем: data_dst.mp4 и data_src.mp4. Перед этим — проверяем код на совместимость.

Теперь можно скачивать рабочую среду. Вы увидите код с информацией, и в конце — информацию об успешном подключении к среде графического процессора.

В качестве примера в версии DeepFaceLab для PC лежат два тестовых видеоролика. С роликами удобнее всего работать через Google Документы — если вдруг вам нужно будет работать с программой целой командой.

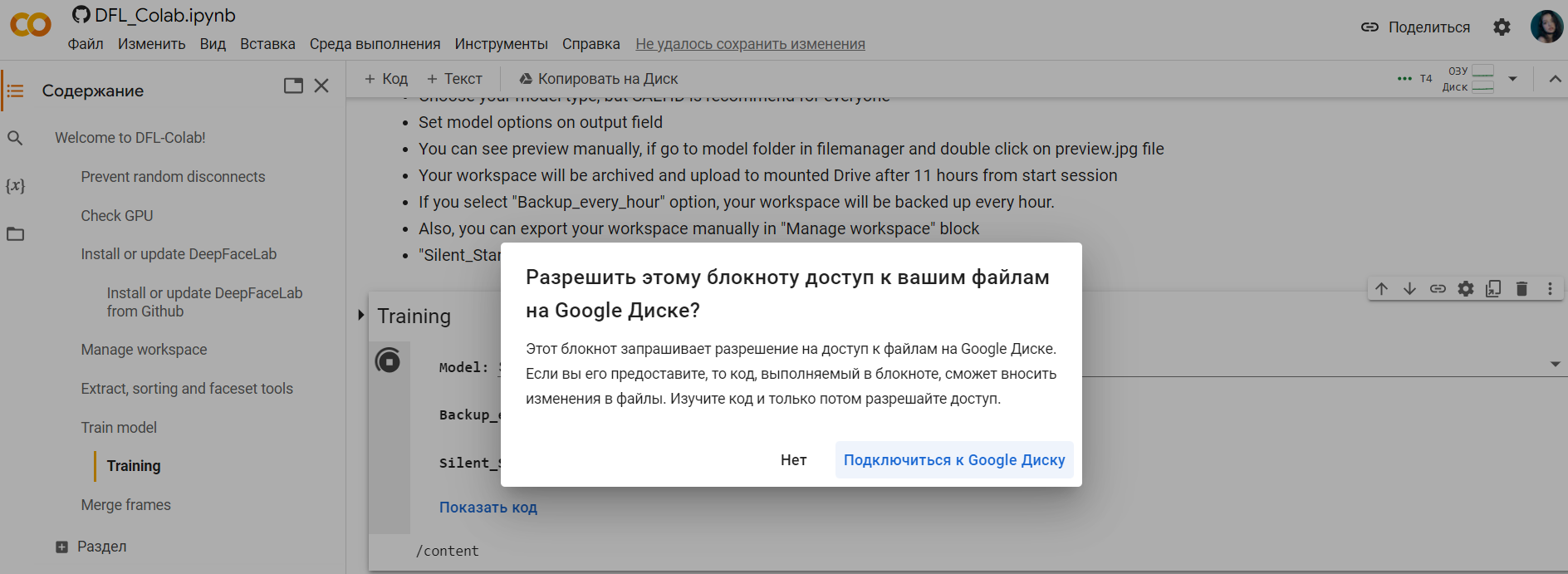

Загрузите архив на Google Drive, затем укажите код «Import from Drive» и разрешите доступ к вашему хранилищу. Далее будет распаковка файлов. Первые несколько раз распаковка может быть неудачной и подключение к Google Drive остановится. Не переживайте и пробуйте еще — в итоге вы должны подключиться.

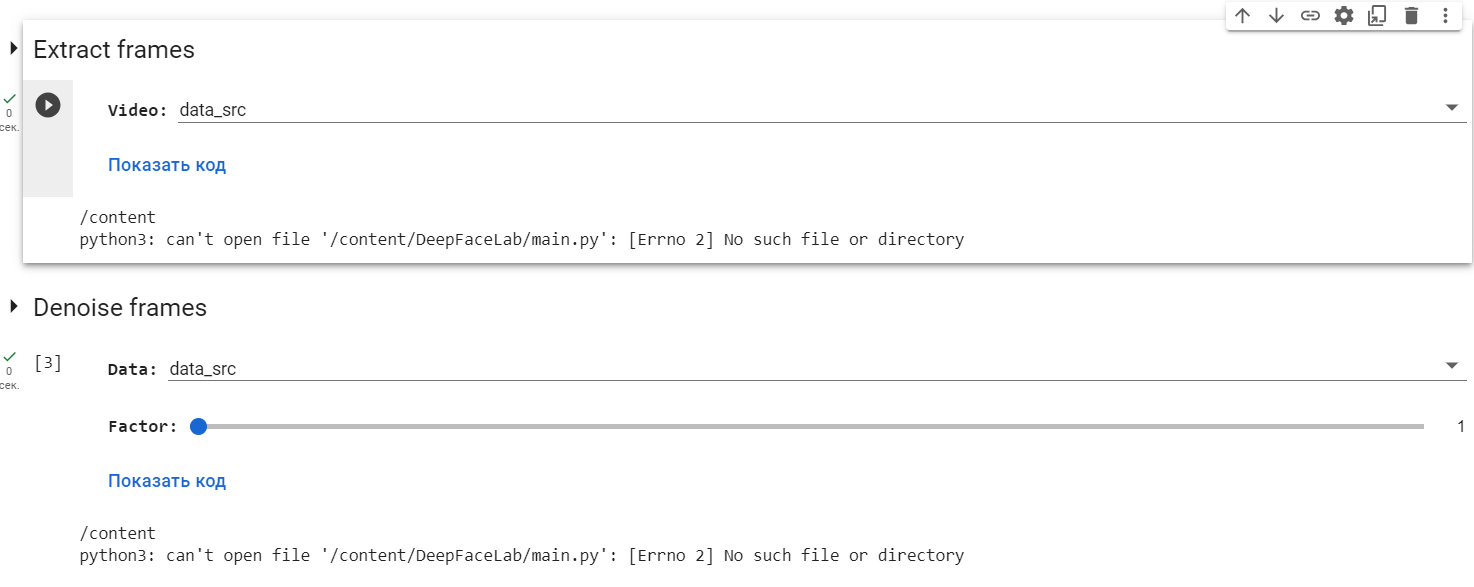

Далее запустите код «Extract Frames» для data_src и для data_dst.

Приступаем к работе с нейросетью. Начинаем с выравнивания кадров. На этом этапе нейросеть находит и вырезает лица с каждого кадра, все происходит благодаря запуску кода «Detect Faces». Сначала подключаете для одного файла, а потом для другого.

После того как процесс завершится, все материалы появятся в каталогах workspace\data_dst\aligned и workspace\data_src\aligned. Так что результат будет доступен во вкладке «Файлы». Дальше вам нужно будет удалить неудачные кадры, и всю работу скачать себе на компьютер.

Перенос лиц будет содержать больше параметров. Переходим в обучение.

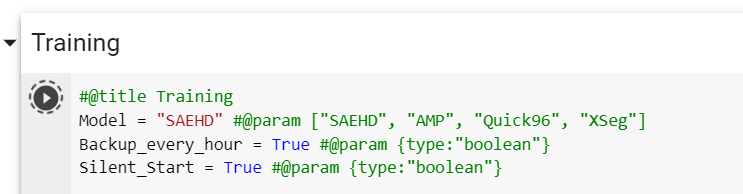

Начинаем с галочки на «Backup every hour». Обновление среды, в которой вы работаете, будет происходить каждый час. Так вам не придется начинать проект с нуля. Дальше вы вводите имя модели, а остальное — оставляете по умолчанию.

По окончании тренировки «новое лицо» следует вклеить в целевое видео. Для этого используйте пункт «Merge Frames».

При его запуске надо будет задать параметры слияния. Вы можете ориентироваться на таблицу ниже.

| Параметр | Для чего |

| [1] Choose mode: | Вариант слияния. 0 — original — не меняет лицо, 1 — простое наложение, 2-6 — различные варианты смешивания. |

| [4] Choose mask mode: | Режим маски. |

| [0] Choose erode mask modifier (-400..400) : | Изменение размера маски наложения. |

| [0] Choose blur mask modifier (0..400) : | Размытие края маски. |

| [0] Choose motion blur power (0..100) : | Размытие в движении. Чем больше смазанных мест на картинке, тем больше этот параметр. |

| [idt] Color transfer to predicted face (rct/lct/mkl/mkl-m/idt/idt-m/sot-m/mix-m) : | Выбор функции сопоставления цветов кожи источника и назначения. |

В итоге остается запустить код «Get result video». Все сохранится в едином файле на вашем Google Drive. Подробная инструкция по всем шагам есть здесь.

| Минус этой программы: чтобы докрутить результат до максимального, придется это все делать вручную и больше разбираться с данными, меняя параметры слияния на этапе обучения. |

Есть и другие программы, которые помогают с разработкой дипфейков. К самым популярным можно отнести:

- Faceswap — бесплатная полноценная программа для создания роликов, которую нужно обучить. Обучение занимает до 2-3 недель, для этого выгружаются видеоролики с разными лицами. Интерфейс программы сложный, подходит для продвинутых пользователей, которые знают про работу с нейросетями.

- Deepfakes web — платная программа, которая в течение часа меняет лица местами. Чем больше роликов вы загружаете — тем лучше итоговый результат. Стоимость одного часа составляет 2$.

- Visper — нейросеть от Сбера, больше подходит для создания простых видеороликов, так как перенос лиц здесь недоступен.

Еще есть приложения, которые быстро переносят лицо с одного объекта на другой. Но такая хитрость видна всем. Остальные продвинутые сервисы недоступны в России, либо слишком сложные даже для тех пользователей, кто знает про работу с нейросетями.

Личная безопасность: как дипфейки помогают проходить верификацию

С 2022 года по первый квартал 2023 года мошенничество с дипфейками растет. За это время количество фейковых роликов на фоне всех остальных видов мошенничества выросло на 1200% в США, на 4500% в Канаде и на 392% в Великобритании. То есть, ни одна часть мира не застрахована от этой технологии.

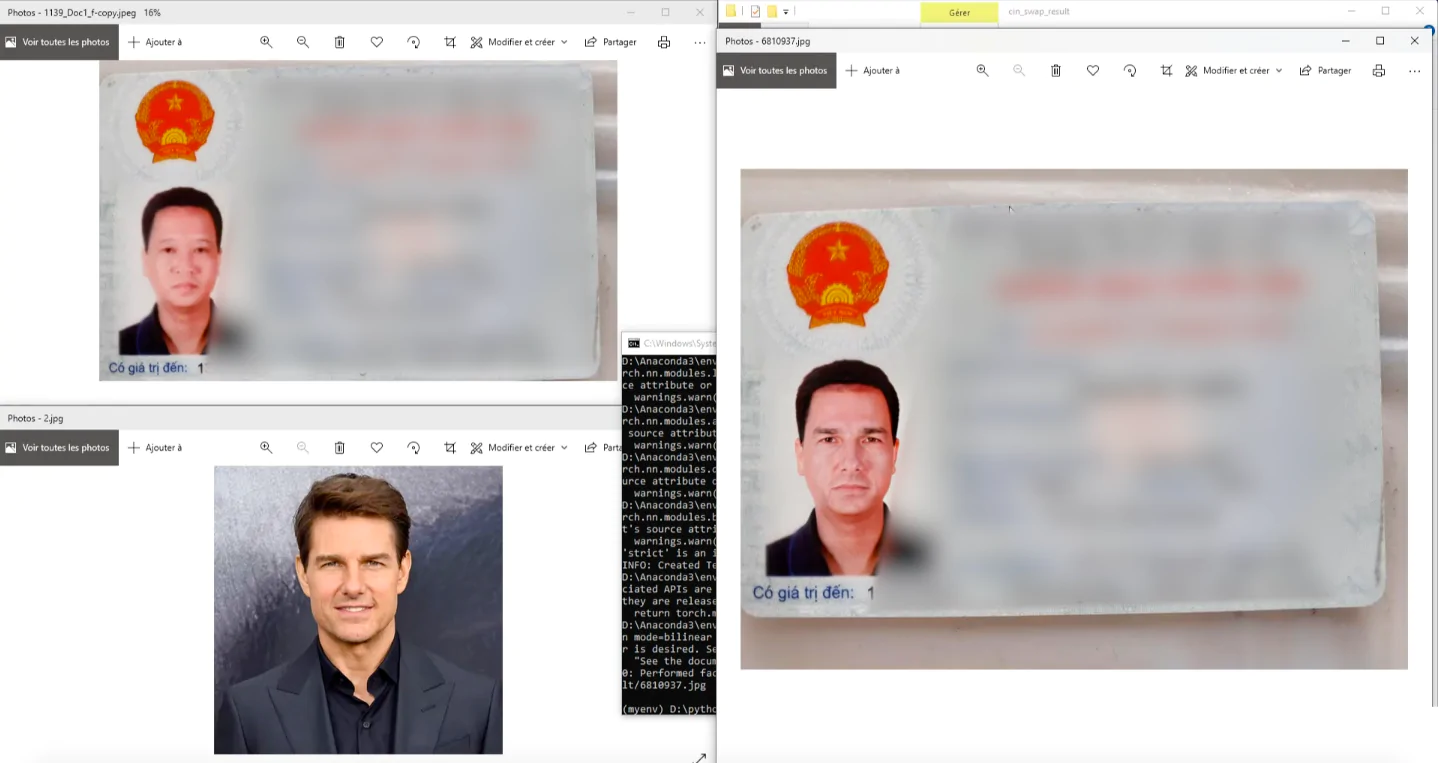

Чаще всего мошенничество связано с созданием фальшивых аккаунтов, паспортов или документов. Например, подобная подмена в Китае при помощи дипфейков вызвала крупное мошенничество против налоговой системы в 2021 году.

С помощью технологии дипфейков киберпреступники могут использовать этот вариант для получения доступа к ранее недоступным или защищенным учетным записям.

Уязвимыми отраслями стали сферы, работающие и взаимодействующие с клиентами удаленно. К ним относятся — финтех, азартные игры и криптоплатформы. Компании, от банков до криптовалютных бирж, обращаются к верификации на основе изображений и видео.

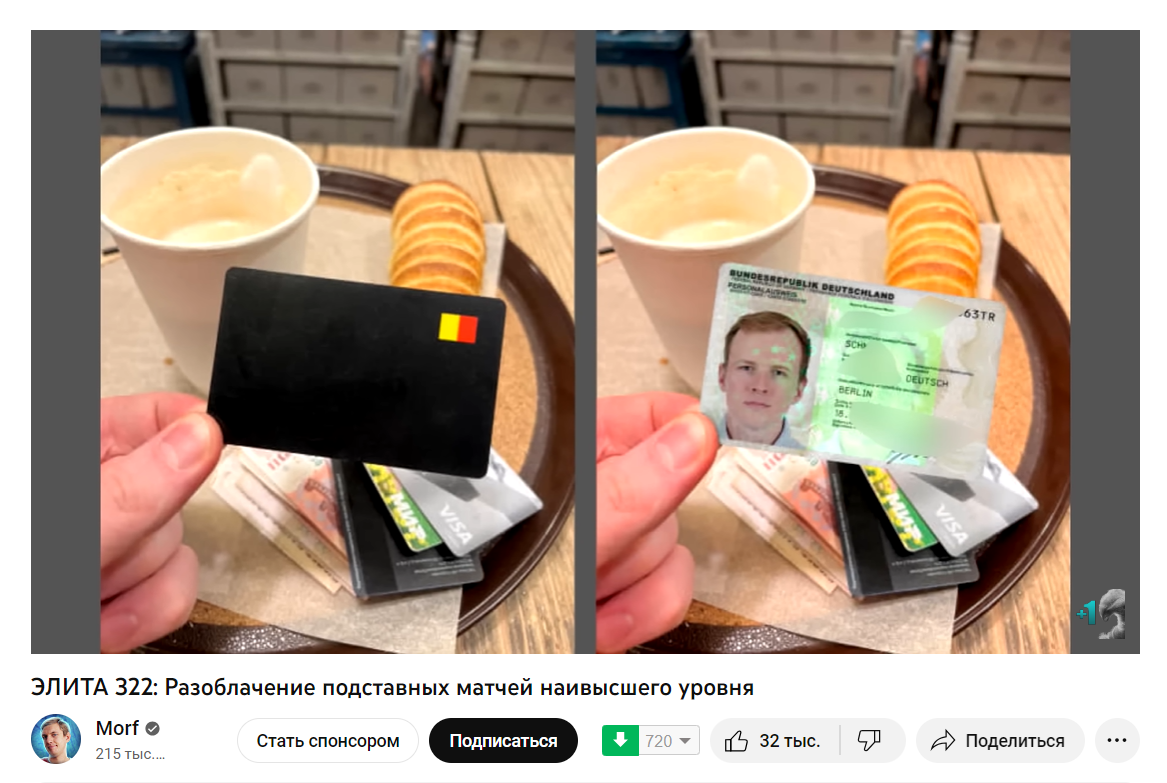

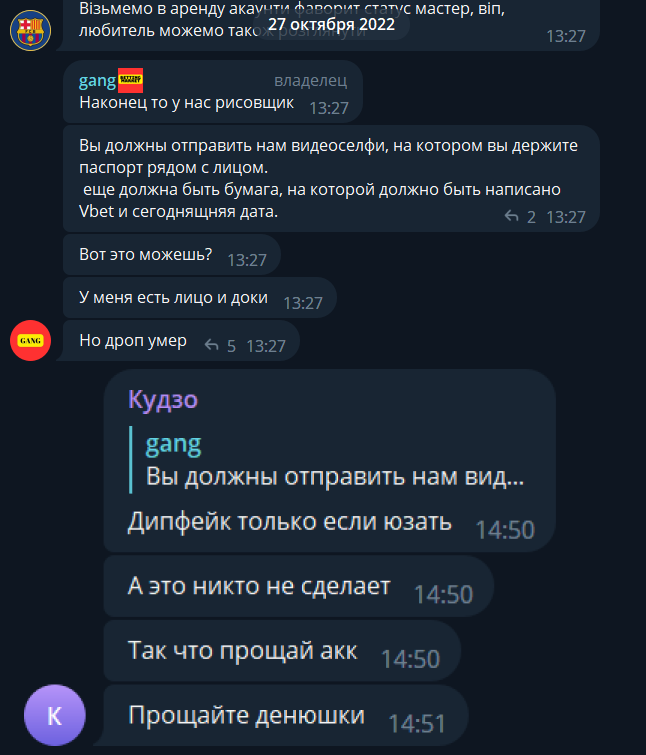

Большинство этих компаний требуют, чтобы пользователи загружали официальное удостоверение личности, селфи или специальное фото на основе таких инструкций, как поднятие пальцев или удержание заметки. Технологии дипфейков позволяют обходить эти проверки. Например, недавно блогер Morf сделал разоблачение подставных матчей. Там он также упоминал обман с прохождением верификации букмекерских контор.

Это заметно упростит работу профикам в букмекерских конторах: с такой технологией не нужно быть на постоянном контакте с дроповодом или самим дропом.

| Проблема этого способа прохождения верификации в том, что букмекерские конторы всегда могут попросить дополнительные документы, чтобы убедиться в реальности человека. |

Пока что качественная технология замены лиц на фото и видео сложная. Есть приложения, которые заменяют лица, но этот обман очевиден. Поэтому для прохождения верификации они не подойдут. А возиться с нейросетью неделями и обучать ее правильно менять лица, использовать код для замены параметров и найти большое количество фото или видео человека, чье лицо нужно использовать.

Некоторые ребята уже пытались использовать дипфейки для обхода верификации в букмекерских конторах. Например, Денис, участник одного из форумов, в своем интервью на Lenta.ru рассказывал, что такая технология облегчает идентификацию по видео. И хотя это большой прорыв для «вилочников», хотя и требует времени и денег для создания фейковых аккаунтов.

Интересный опыт и попытки пройти верификацию с помощью этой технологии описал пользователь Jimbo. Там он тестировал 8 нейросетей. Из них только 3 помогли пройти проверку, а остальные 5 попыток были неудачными.

Но пока что даже в их сообществах нет понимания, как можно эффективно использовать фейковый контент с переносом лица реально существующего человека.

Если же технология станет популярной среди игроков и будет проста в реализации, то проходить верификацию можно будет куда проще, чем сейчас. Хотя уже сейчас улучшаются не только дипфейк-технологии, но и нейросети по их распознаванию.

А что говорит закон о дипфейках?

Дипфейки во многих странах легальны, и правоохранительные органы мало что могут с ними поделать несмотря на серьезные угрозы. Фейковый контент становится незаконным только тогда, когда нарушает существующие законы, такие как детская порнография, клевета или разжигание ненависти.

Если же автор указывает, что это фейк, то никаких действий в его сторону от представителей закона не будет. Даже если ролик оскорбительный, то использование лица в развлекательных целей никак не нарушает ни авторское право и не причиняет вред репутации.

| По российскому законодательству — в п. 4 ст. 1274 ГК РФ предполагается, что контент в жанре литературной, музыкальной или иной пародии, который создали на основе другого, можно опубликовать без разрешения автора. |

Так что люди не смогут подать заявление или иск, если их лицо или творчество используют для фейкого контента.

Где еще используют дипфейки

Дипфейки ассоциируются в основном с мошенничеством или порнографией. Но есть много сфер, где можно встретить фальшивые изображения или видеоролики. К ним относятся:

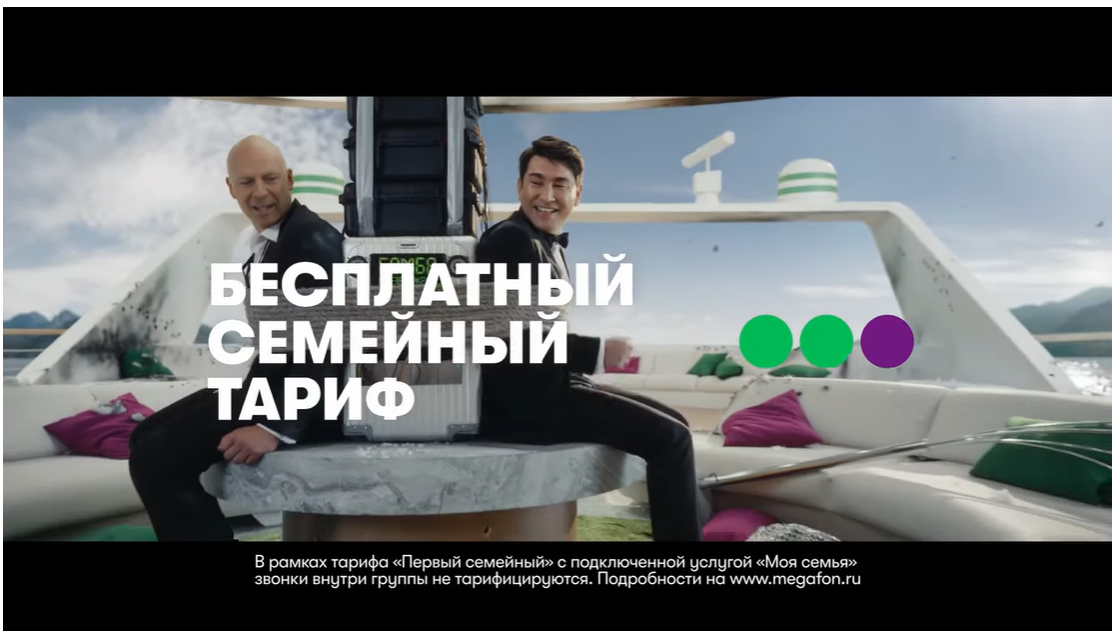

- Маркетинг. Бренды и компании используют для продвижения своих услуг фейковые видеоролики. Обычно в этих роликах накладывают лица знаменитостей. Например, Мегафон для рекламы нового тарифа использовал дипфейк Брюса Уиллиса.

- Образование. В 2019 году университет в США использовал технологию дипфейков для создания виртуальной лекции известного ушедшего из жизни учёного. Цель — предоставить студентам доступ к историческим знаниям и идеям выдающихся деятелей.

- Журналистика. Новости используют такие ролики для создания имитации интервью с противоречивой фигурой, что позволило репортерам задавать вопросы и получать ответы без необходимости реального взаимодействия.

- Кинопроизводство. Создание фильмов — затратный процесс с арендой камер, студий и оплатой работы актёров. Иногда это помогает присвоить тот или иной рейтинг фильму. Например, авторы триллера «Вышка» использовали дипфейки, чтобы выпустить фильм в прокат с мягким возрастным рейтингом. Переснимать такой фильм — дорого и затратно, проще использовать нейросети для редактуры фраз.

- Виртуальная реальность. В 2019 году игровая компания использовала технологию Deep Fake для создания гиперреалистичных персонажей и окружения в игре виртуальной реальности, предоставляя игрокам захватывающий опыт.

- Политика. Политические дипфейки — одни из самых интересных и качественных. Их используют для манипуляции населения, для подрыва репутации политических оппонентов или подорвать их политическую позицию. Вот, например, видео, где Дональд Трамп «признает свое поражение» через 2 месяца после выборов. При внимательном рассмотрении можно увидеть, что ролик фейковый, но мало кто будет присматриваться.

Фейковый контент нас развлекает, но в то же время он стал мощным оружием для мошенничества и киберпреступлений. Например, в 2020 году группа преступников использовала дипфейки, чтобы обмануть британскую энергетическую компанию на 40 000 фунтов стерлингов, выдав себя за генерального директора в серии электронных писем. И таких случаев становится все больше.

Кибербезопасность также оказалась под угрозой — технология дипфейков повышает эффективность фишинга и упрощает проведение мошеннических операций, связанных с корпоративной репутацией.

Заключение

Дипфейки представляют собой мощное средство создания видео- и аудиоматериалов, которые могут быть почти неотличимы от реальных. Их потенциал для развлечения, образования, исследований и безопасности огромен.

Хотя они и стали доступны всем пользователям интернета, мало кто из них действительно могут использовать эту технологию в своих целях. Для создания качественного фейкового контента потребуются несколько дней, а иногда и недель, чтобы обучить нейросеть правильно обрабатывать видео и делать незаметную замену лица. И пока не все готовы тратить на это время и силы.